ゼロから作るDeep Learning

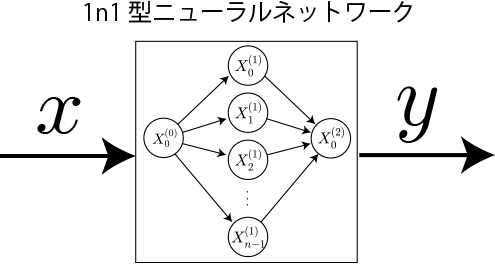

1n1型2層ニューラルネットワークで1変数関数を学習させてみる3:ニューロン数による学習効果の違い

昨今注目を集めているAI(人工知能)を学びたいと思い立ち、ディープラーニング(Deep Learning、深層学習)と呼ばれるAIの数理モデルである多層構造のニューラルネットワークを書籍「ゼロから作るDeep Learning ―Pythonで学ぶディープラーニングの理論と実装」を参考にを独習していきたいと思います。本書籍ではプログラミング言語としてPythonが利用されていますが、本項ではJavaScriptで実装していきます。

目次

- 準備1:行列の和と積を計算する関数の実装

- 準備2:ベクトルと行列の積を計算する関数の実装

- 準備3:多変数関数の数値微分と極小値の探索

- 1.1層ニューラルネットワークの実装(バイアスなし、活性化関数なし、学習なし)

- 2.1層ニューラルネットワークへのバイアスと活性化関数の追加

- 3.1n1型2層ニューラルネットワークの実装(学習なし)

- 4.1変数関数を学習させてみる1:勾配法による学習計算アルゴリズム

- 5.1変数関数を学習させてみる2:勾配法による学習計算アルゴリズムの実装

- 6.1変数関数を学習させてみる3:ニューロン数による学習効果の違い

- 7.誤差逆伝搬法(バックプロパゲーション)の導出

- 8.順伝播型ニューラルネットワーク「FFNNクラス」の実装(JavaScript)

- 9.三角関数のサンプリング学習(WebWorkersによる並列計算)

- 10.学習後の各層ニューロンの重みの可視化

- 11.層数とニューロン数による学習効果の違い

ニューロン数による学習効果の違い

入力と出力が1個、隠れ層が10個のニューロンで構成されるニューラルネットワークで学習した前項の3次関数の学習を題材にして、ニューロン数を変更した場合の学習効果の違いを検証します。

横軸:ニューロン数、縦軸:損失関数

次のグラフはニューロン数に対する損失関数の値(10回の平均値)です。3本のグラフは学習回数1000回、2000回、3000回に対応します。 (※)読み込みごとに計算しているためグラフ表示までに10秒程度掛かります。

実行ごとに若干のばらつきはありますが、ニューロン数は多い方、学習回数は多い方が損失関数の値が小さくなり、うまく学習できていることがわかります。 3次関数の場合には、ニューロン数7個で2000回程度で概ね表現できていることがわかりました。今回は隠れ層が1層でしたが層数の依存性も今後検証していきます。